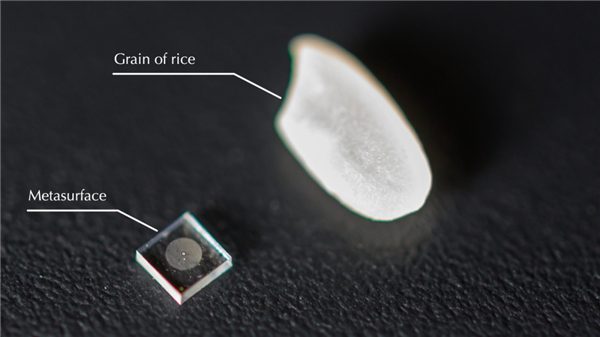

先来猜一下图上的东西是什么。

你能想到它竟然是一个相机吗?并且还是能正常拍摄的那种。

别看它长得还没一粒米大,拍出来的照片效果可是一点都不差。

有图有真相。

左边是超微型相机拍摄的照片,

右边是普通光学相机拍摄的照片。▼

超微型相机拍出来的照片,除了边缘有点模糊外,该有的细节它都能 “ 看得见 ”。

这还不算,就连录视频也被它玩得明明白白。

左边是普通相机拍摄的视频,

右边是超微型相机录制的视频。▼

视频里的花瓣纹路丝丝分明,我拿自己的眼睛都不一定能看得到这些细节。

所以这枚比瞳孔还小的相机,为什么可以看得这么清楚?

这要归功于一种叫做 “ 超构表面 ” 的新材料,这是超微型相机明察秋毫的关键,它与传统的光学构件有着完全不同的光学性能。

传统镜头需要将不同功能的透镜组合起来使用,把光线调整成合适的光路。

而透镜调整光路的理论核心,是光波在材料中减速通过。

透镜的不同区域有薄有厚,光波通过透镜的时间有早有晚,最后几束光线汇集形成虚像的位置,就会落在最晚穿过透镜的一束光线方向上。

简单来说,让不同区域的光线花不同的时间通过介质,就能控制光路的方向。

在传统的方式里,光波通过材料的速度是由介质本身决定的。要改变介质的光学性质也不是不行,我们可以想办法调整温度、压力、内部分子排列方式,但这种方式微操起来十分困难,成本很高。

所以,科学家们研究起了更可行的方案。

既然成像的本质是改变光通过介质的时间,那就换一个方式来达成这个需求。

咱们物理课上学过的光的衍射,也可以改变光波通过的速度,只要障碍物尺寸小于光波的波长,就可以让光线绕一次远路。

多设置几个障碍物,光线就得多走一段时间,实现人为控制光速。

“ 超构表面 ” 的工作原理就在于此,介质的不同区域中设置了不同的障碍物,让人为设计光路成为可能。

在这枚超微型相机的 “ 超构表面 ” 上,按规律排布了 160 万个形状各异的圆柱体作为障碍物,光线通过这些障碍物群会被调整成规定好的路线传输给感光元件。

把这些圆柱体放大看一看。

图上密密麻麻的柱子和空隙,就是光波需要走的路,不同尺寸的圆柱体群对不同波长的光发挥作用,引导光线顺利进入到感光元件。

但是考虑到圆柱体各自的形状设计和它们的数量,要让光路完全符合人类的设计,成功的可能性比大大小小所有考试全部拿满分还要再小上几个数量级。

能达到的最好效果是什么样呢?传给感光元件的画面,是这个样子滴。

这,摘了眼镜看实物也就那样了吧,这块镜头散光有点严重啊。

得想个办法把光影聚拢回来,才能得到高清大图。

既然是光线聚焦能力欠佳的问题,不如先拿一个光点来研究一下,应该给镜头配一副多少度的 “ 眼镜 ”。

其中的原理嘛,就是把感光元件接收到的光信号全部扔给 AI 去处理喽。

反正它们算得比人快,可以在不断的试验和结果反馈过程中取得最优调整结果,比眼镜店的老板给你测视力都快。

光是把晕出去的光圈收回来还不够,必须再让 AI 重描一次边。

这个提取强化轮廓特征的步骤,就是经典老片转 4K 的反卷积操作,描边过程中还可以顺便矫正一下畸变,补充一下像素让画质更清晰。

经算法处理后的照片,变成了这个样子。

照片处理得确实不错,那么放在视频上能不能行呢?

处理后的视频效果,已经到了可以与智能手机相媲美的程度。

不得不说,超微型相机不仅光学材料的性能牛,算法也同样强大。有了这一份算法加持,无论镜头多烂,画质都能救回来。

这种除外 ▼

不过也正是因为需要有强大的算法来还原画质,镜头和显卡,你相机总得烧一个吧。

开发人员的初衷是为了解决医疗器械的应用范围局限性,能够让纳米级镜头代替人眼窥探病灶,为纳米机器人的发展叠 buff。

但是,超微型相机,这个词单拎出来就足够让人警惕了,更不用说拍摄质量还那么高清。

技术是一门好技术,有没有被带歪还得看人了。