长久以来苹果公司一直将保护用户隐私作为公司当中最重要的一件事情,并且我相信,苹果对于用户隐私的保护工作是每一位苹果用户都有目共睹的。

甚至说苹果对于用户隐私的保护稍微有那么一点过头了。

还记得在2015年,某个恐怖分子被美国当局击毙,但是当FBI想要查看恐怖分子手中苹果手机内容的时候却遇到了重重困难,为此FBI找到了苹果公司,希望能获得苹果公司的帮助来查看手机当中的内容。

但是苹果公司却表示,我们不能让你们(FBI)查看死掉的恐怖分子手机当中的详细内容,我们要保护每一位用户的隐私。

并且苹果也一直把用户隐私保护作为自己宣传时的一个重点内容。

在2020年9月份的时候,苹果甚至还发布了一个广告——Over Sharing(过度分享),来向广大消费者介绍iPhone的隐私保护是多么的厉害,视频描述了人们尴尬地与陌生人分享他们的个人信息,例如信用卡号,登录详细信息和网络浏览历史记录。

苹果表示:“有些事情不应该共享。”“这就是为什么 iPhone 旨在帮助您控制信息并保护隐私的原因。”

苹果一再认为用户隐私是一项“基本人权”,是公司的“核心价值观”,在2019年CES展的时候,苹果甚至包下来了一个酒店的巨幅广告位置。

在广告上写着“What happens on your iPhone stays on your iPhone”(在你iPhone上面发生的事情只会留在你的iPhone上面),以此巨幅的广告表达苹果公司对用户隐私的重视。

你看到这里是不是就会感觉到苹果对于每一位用户隐私的重视程度是非常高的,比某些安卓手机不知道好到哪里去了,下载一个简单的点外卖APP就会向你索要38项用户权限。

甚至还要识别你的身体活动,看到这里我一个安卓用户实名羡慕苹果对于用户隐私的重视程度了。

但是这样的重视程度会一直持续下去吗?

答案是不会的,就在前几天苹果公布了一项新的技术,这项技术打破了其一直在坚持的所谓的重视用户隐私。

苹果于近日发布了一项全新的用于扫描检测“儿童性虐内容(Child Sexual Abuse Material)”的端侧工具,那什么是端侧扫描呢,意思就是扫描工作将在用户设备上完成。

为了完成“儿童性虐内容”的检测,iOS与iPadOS将搭载一项最新技术,这项技术可以使苹果检测在各类苹果设备上面接收、保存或者发送的照片提取哈希值。

然后苹果会用提取到的哈希值和“全国失踪和受剥削儿童中心(NCMEC)”和其他儿童安防组织提供的已知儿童性虐图像的哈希(散列)数据库进行比对。

以此来验证某些照片或者图片是不是属于儿童性虐内容,苹果表示这个数据库将被转为一组不可读的散列,安全地存储在用户的设备里,之后在用户设备之中进行比对。

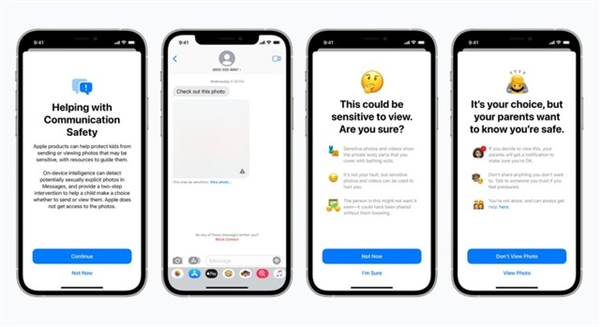

如果系统认为这张照片属于露骨性照片时则会模糊处理,iMessage会警告儿童,并再次确认儿童是不是想继续浏览或者发送露骨性照片。

除此之外,儿童再次预览或者发送露骨性照片,APP还会自动通知家长。

你看到这里是不是会觉得,嗯!这些检测都是为了孩子的身心健康着想啊,而且检测工作都是在本地完成的,这跟用户隐私有什么关系呢?

上面这些内容看起来还算是正常,不急,我们继续往下看。同时在苹果的介绍中还可以发现,苹果也会使用类似的算法对用户发送到iCloud上面的照片进行检测,在上传到服务器之前,会给文件进行一连串的加密工作。

如果上传到iCloud照片完成哈希值的比对之后,认为照片存在儿童性虐内容的话,苹果的服务器就会对照片进行解密,并且由人工进行查验。

有专家认为,尽管苹果提议CSAM方案的初心是好的,且针对此类违法行为的打击是绝对正义的。

虽说最近苹果相关负责人多次声明,CSAM方案不会导致其软硬件留下后门,并且会防止政府过度干预和滥用,但是对于用户来说只要这项技术实装,多少都会让自己不放心。

苹果将在不远的将来偷偷的“欣赏”你系统里面存储着的照片,并且最近有关于这项新技术的讨论越来越多,但是绝大多数的讨论都是围绕着用户隐私还是不是苹果最重视的事情。

之前说的什么“What happens on your iPhone stays on your iPhone”恐怕将会成为广大苹果用户心中最美好的愿景。

哦对了!还有一点你必须要知道这项新技术将在iOS 15系统中首发,尤为重要的是这项技术目前只会在美国国内上线,对于咱们国内消费者来说没有这么多需要担心的。

支付宝扫一扫

支付宝扫一扫 微信扫一扫

微信扫一扫