万圣节要来了!

两千多年前,凯尔特人相信,严寒的第一天,故人的亡魂会回到故居地在活人身上找寻圣灵,借此再生,这是人死后获得重生的唯一希望。

而活人则惧怕死人的灵魂来夺生,于是在10月31日这一天人们熄调火炉,把自己打扮成「妖魔鬼怪」把魂灵吓走。

后来,欧洲基督教会便把11月1日定为“万圣节”,并一直延续到了今天。

不过,如今万圣节已经变成了人们娱乐、恶搞的节日,人们尤其热衷于制造诡异的面部妆效捉摸朋友。

但通常一个令人惊恐的“丧尸妆”要花费十几个小时,多少有些让人头疼。

那么,有什么方法可以一键生成惊悚的丧尸妆呢?

现在距离万圣节还有3天,但小编已经在国外社交网络上发现一大波丧尸照,我们来一起感受下~

emmm,妆效过于专业了。

难道新一季《行尸走肉》又要开播了?还换了演员?

还有两位总统候选人约瑟夫·拜登和唐纳德·特朗普,恐怖又觉得有点搞笑……

看到这里,有朋友可能会想到这些图片应该是来自网友们的恶搞。

是的,这些真·丧尸全部出自一款『丧尸生成器』,只需输入一张照片就可以立刻生成一张丧尸照,而且妆效感人……

不知道大家还记不记得,之前小编曾报道过一款换脸网站Toonify,这个网站可以把人脸切换成动漫脸,效果非常逼真,上线当天访问量就超过了25万。它效果是这样的:

大眼萌脸,妥妥地定制化漫画脸,正是这款变脸网站,激发了Josh Brown Kramer的灵感。

既然一张照片可以秒变迪士尼公主,是不是也可以让它秒变丧尸呢?

因此,这位程序员小哥借鉴了Toonify的核心技术,开发了这款『丧尸生成器』,而且为了方便大家使用,也做成了网站形式,可免费使用。

听到这里是不是迫不及待想要体验一下了?

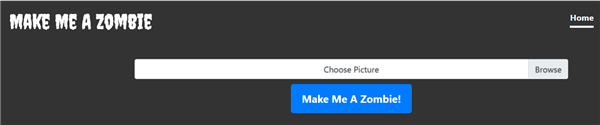

该网站名为Make Me A Zombie。操作简单,出图很快。https://makemeazombie.com/

只需要点击链接,选择Browse输入一张人脸图片,点击蓝色图标即可。

小编没忍住用爱豆们的照片先体验了一番,结果…..

不过,马老板这张,感觉特效化妆师都画不出这样的妆效。

言归正传,经过几张图片测试,小编也发现两个问题。一是生成器只针对面部进行识别和处理,如果输入全身图,系统会自动删除多余的部分,只生成一个人脸照。

二是输入人脸照的生成效果比全身照更好,而且图片越清晰效果也就越好。

有了这个“丧尸生成器”,万圣节不愁恶搞别人的“鬼照”了[奸笑]

Kramer介绍称,该模型的开发与 Toonify 并无关联,但使用的是相同的技术栈,即StyleGAN2.

StyleGAN是当前最先进的高分辨率图像合成方法,由英伟达在2018年首次推出。该方法可生成逼真的人脸图像,其在FFHQ(Flicker-Faces-HQ)数据集上的表现,远超DCGAN和ConditionalGAN。

但StyleGAN也存在明显的缺陷,即易出现斑点似的伪影(Artifacts)。

去年12月,英伟达在StyleGAN原有架构基础上进行了改进,并于CVPR 2020大会上推出升级版StyleGAN2。

除了消除伪影外,StyleGAN2的一项重大更新是风格迁移(Style Transfer)技术。

该研究团队在论文《分析和改善StyleGAN的图像质量》中指出,“总体而言,我们改进的模型在现有的分布质量指标和感知的图像质量方面都重新定义了无条件图像建模的最新技术。”

简单来说,该模型可以使用迁移学习技术生成各种风格的肖像,突破了图像合成的风格限制。我们现在通常看到的人脸动漫化,或者动漫脸真人化本质都是利用的这张技术。

例如:这是利用StyleGAN2在五种动漫和动物角色之间的无缝切换。

Kramer利用这项技术创建了一个混合型 StyleGAN2 模型。其中,该模型前层为人类图像生成器,后层为丧尸生成器。在数据集方面,人类图像生成器采用的是高质量的人脸数据集FFHQ,它包含70,000张PNG图像,分辨率达1024×1024;僵尸生成器的训练数据是一组包含300张万圣节僵尸装扮的人的图像,主要来自Pinterest和Google,并对其进行了手动检测删除了非僵尸图像。

最后,在借鉴《StyleGAN2 Distillation for Feed-forward Image Manipulation》论文后,Kramer转存了50000 个图像对(分别来自人类生成器和丧尸生成器),并使用 Pix2PixHD 学习图像对之间的映射。

此外,Kramer也强调其与Toonify有两点明显的不同:

我通过“crappify”的方法来调整图像大小,并压缩伪影。

我们采用的混合模型不同。我的模型更强调原始图像的形状和方向,以及僵尸图像的纹理和卡通化,而Toonify并不是。

值得注意的是,关于僵尸生成器,Kramer从去年开始就有做过尝试。当时利用的是CycleGAN模型,但采用的数据集是一样的。起初,Kramer想研发一半是人像一半是僵尸的生成器。他将数百个示例分为两类,分别学习带有SVM的超平面,以确定潜在空间中的“僵尸”方向。接着再根据输入的人脸生成特定的“僵尸”,并以此作为 Pix2Pix 数据的基础。

但这一过程遇到了两个问题:一是虽然在生成的人类身上效果很好,但在真实图像上只能产生中等水平的结果;二是僵尸和种族之间性质不同,我不想创造一个改变种族生成器。

不过,相比之下,基于StyleGAN2架构的模型也有明显的优势。比如该模型能够在2080Ti显卡上训练1024 x 1024大小的模型,效率高,而且经过预训练后的输出效果也比较好,在这两点上CycleGAN2和Pix2PixHD相对差之。

支付宝扫一扫

支付宝扫一扫 微信扫一扫

微信扫一扫