图灵奖得主 Yann LeCun 之前一直因为卷入骂战而宣布退出推特界,结果最近,网瘾大叔坐不住了,经常出来冒泡。

就在两个月前,他还声称,这是我在推特上最后一篇有内容的帖子,大家再见。

看他现在的状态,PULSE 的风波好像早已经翻篇儿了。

这一次主要还是为自家产品 Facebook AI 最新打造的 3D 嵌入式智能体训练视听平台打 call,平台可以训练 AI 智能体成为一个完美助理。

你有没有这种体验,

每次一出门就忘记自己的钥匙放哪儿了?

我把咖啡杯放哪儿了?

出门到底有没有关门?

每到这种怀疑人生的时候,有虚拟助理来帮你打理一切就再好不过了。

Facebook 近日发布的三项研究具有里程碑式的意义,意味着虚拟助手可以像人一样与现实世界进行互动了。

他能够学习如何规划路线,环顾周围的物理环境,倾听周遭的一切,甚至建立 3D 空间的记忆。他可以帮你检查门是否上了锁,或者楼上卧室里响个不停的手机到底是咋回事。

最新的发布是基于此前开源的 AI Habitat 仿真平台(内置支持 Facebook Reality Lab 的仿真虚拟环境数据集,以及 Matterport、 Gibson 和其他数据集)

Habitat 仿真环境数据集

AI Habitat 能够高效地在逼真的 3D 环境中训练虚拟机器人,能够在单个 GPU 上以 10000 帧率/秒的速度运行,比实时速度快 100 倍以上。当然最终都是要将仿真平台上的训练结果迁移到现实世界当中。

SoundSpaces:AI 可以自己「听」到手机铃声

声音在不断地驱动着人类的行为,一个小孩儿的哭声吸引了我们的注意力;玻璃破碎的声音可能需要紧急帮助;孩子们在客厅里和奶奶通电话,所以需要调低电视的音量。

但现在的很多智能体对周围的 3D 世界缺乏这种多模式语义理解,对各类声音「充耳不闻」。

Facebook 最近建立并开源的 SoundSpaces 就是为了解决这一问题: 这是第一个基于复杂 3D 环境下的几何声学模拟的音频渲染数据集。

智能体可以分辨真实世界中声音,比如钢琴课上突然消防警报响了这类情况。

SoundSpaces 建立在 Habitat 的基础上,加载了一种新的音频传感器,可以将任何声源的高保真的仿真结果插入到一系列来自 Replica 和 Matterport3D 数据集的真实世界扫描环境中。

利用 SoundSpaces,我们为嵌入式 AI 引入了一个新的任务: AudioGoal,其中智能体必须通过未映射的环境来查找发出声音的对象,例如电话铃声。据我们所知,这是训练深度强化学习智能体在新环境中「看」和「听」的首次尝试,同时还可以定位发声目标。

与处理以点为目标的传统导航系统不同,这里的智能体不需要指向特定目标位置的指针。智能体接受的指令是「去找响铃的电话」,而不是「去距离你现在位置西南 25 英尺的地方找电话」。它可以通过多模态感知,自己发现目标位置(见下图)。

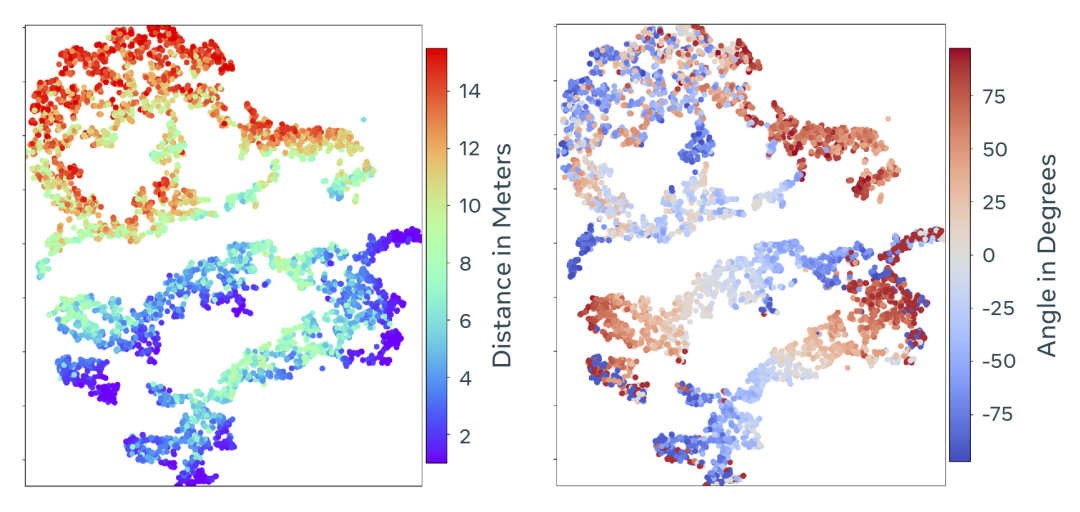

用t-SNE 对学习到的音频特征进行表示,颜色揭示了智能体和目标位置、方向的相关性。红色代表远,紫色是近,蓝色表示在智能体左侧,红色表示在右侧。

最后,Facebook 采用的音频编码能够提供比 GPS 定位更好的空间线索,避免 GPS 的噪声影响,因为室内环境中 GPS 经常定位不准。

语义地图 Semantic MapNet:AI 能记住你把杯子放哪儿了

如果你非常熟悉一个特定的地方,家或者办公室,你一定可以记住很多细节。

训练智能体也是如此,他们还可以凭直觉回答一些问题,比如厨房是否在洗衣房旁边,或者二楼会议室里有多少把椅子。为了建立强大和有能力的人工智能助手,并且能够很好地执行这些任务,就需要训练智能体从第一人称视角来探索、观察和记忆一个空间,然后创建一个第三人称由上至下的 3D 环境语义地图。

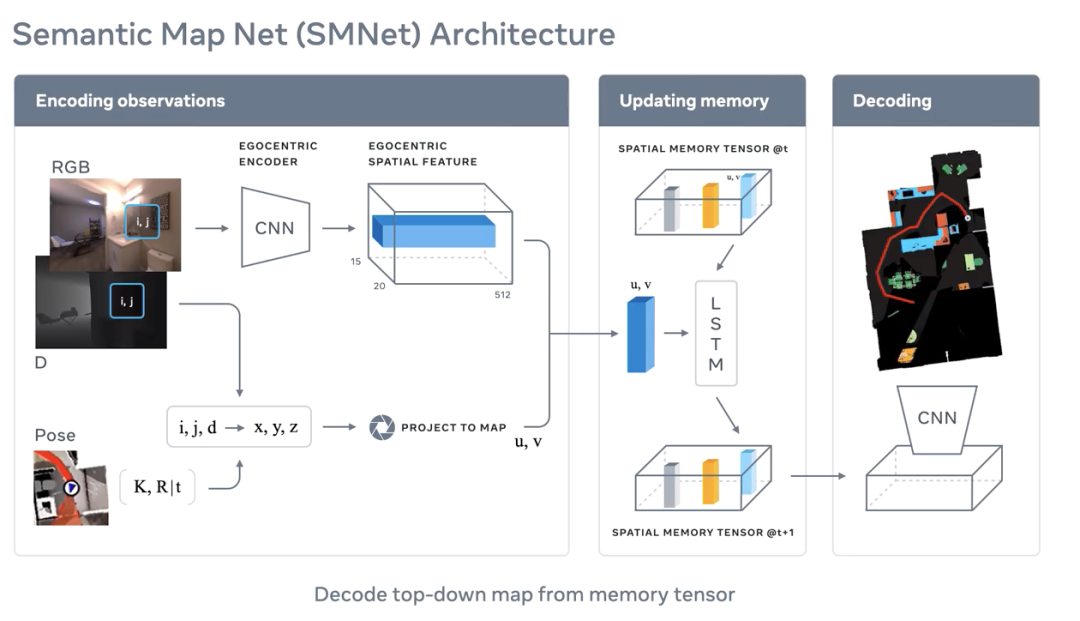

为了实现这一目标,Facebook 建立并共享了语义地图 Semantic MapNet,这是一个用于嵌入式人工智能智能体的新模块。该模块使用一种新的空间语义记忆形式,在探索陌生环境时将观察到的对象「特征」记录在以「自我为中心」的框架中。

这些三维空间的语义表达可以为系统提供一个基础,以完成各种具体的任务,包括问题回答和导航到特定对象位置(沙发、水槽等)。比如,回答开头所说的,我的杯子放在柜子上了吗,这种问题。

MapNet 的原理是,建立了所谓的「多中心」记忆,这是一种记忆表达法,它能够捕获(1) 物体之间的未知视点关系和(2) 物体与环境之间的固定关系。

Semantic MapNet 能够从它的观察中提取视觉特征,然后使用端到端框架将它们投影到特定位置,通过它所看到对象的标签对自上而下的环境地图进行解码。

这种技术使 Semantic MapNet 能够分割出非常小的对象,从鸟瞰视图一般来讲是看不到的。项目还允许 Semantic MapNet 对给定点及其周围区域进行多次观测。

Facebook 写道: 「构建神经记忆片段和空间语义表征的能力对于改进自主导航、移动操作和打造 AI 助理都至关重要。」

通过 RGBD 图像,Semantic MapNet 可以提取自我中心观察到的特征,然后将它们投射到一个分布式张量中的对应位置。然后可以对这个张量进行解码,生成自上而下的环境语义地图。

探索和导航:AI 可以在屋里瞎转悠了

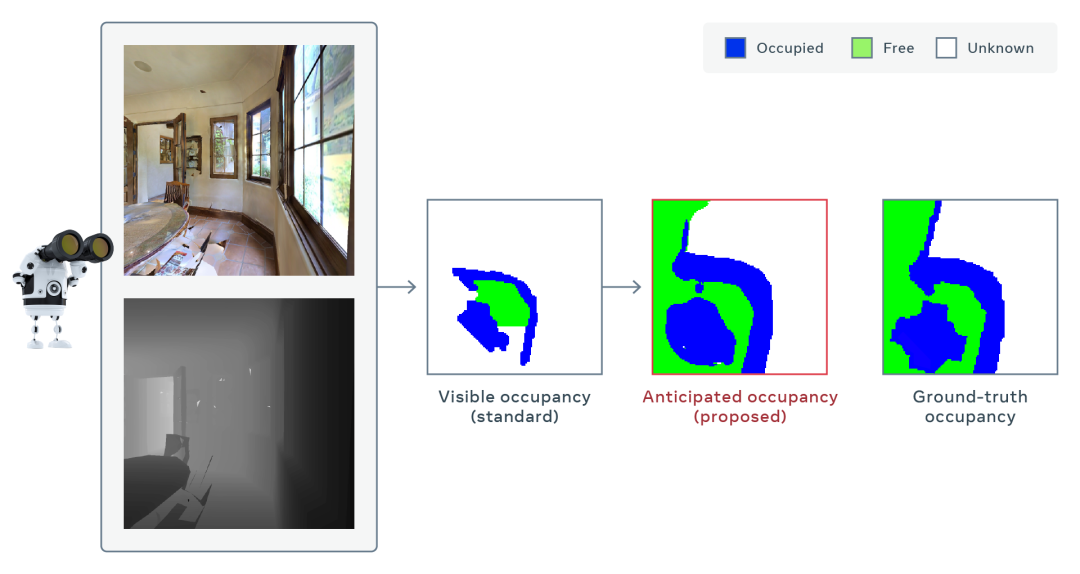

除了 SoundSpaces 数据集和 MapNet 语义地图之外,Facebook 还开发出了另一种模块,可以推断出不能直接观察到的环境地图的某些部分,比如餐厅的桌子后面是什么情况。

在 AI 导航领域,最先进的方法包括 DD-PPO 导航算法,但也仅限于解码 AI 智能体实际在他面前看到的内容。

「我们希望实现,在有障碍物或未绘制地图的区域,也能保持强大的导航能力。为了拓展导航的前沿领域,我们开发了一种「占用预期」方法,在今年的 CVPR Habitat 2020 挑战赛中,这种方法获得了 PointNav 任务的第一名。」Facebook 在博客中写道。

挑战赛的难度在于,要求系统适应低质量的视觉图像(带噪声的 RGB-D 传感器),并在没有 GPS 或罗盘数据的情况下运行。

为了做到这一点,Facebook 引入了一个新的模型,它在正常的观察以外预测「占用」(occupancy,即物体是否存在),同时整合它的预测结果,随着时间的推移,探索出一个导航策略,在环境中自由穿梭。与现有的方法只绘制可见区域相比,智能体通过推断地图中不能直接观察到的部分来更快地建立其空间感知。

比如,在看到餐厅时,智能体预测桌子后面有空闲的空间,或者眼前的墙壁在持续延伸,通向一个看不见的走廊(如下图所示)。因为智能体在创建地图的同时有能力预测它不能直接看到的区域,所以在探索和导航任务中会更快更有效。

Facebook 表示,他们的模型和其他方法相比,只用了三分之一的移动次数,在相同的移动次数下,地图精确度要提升 30%。

可以听你的手机响或是婴儿啼哭做出反应,还能通过记忆判断出楼上有几把椅子,绕过障碍物在屋里随意导航。

这样的 AI 助手是不是有点儿神了?

参考链接:

https://ai.facebook.com/blog/new-milestones-in-embodied-ai

支付宝扫一扫

支付宝扫一扫 微信扫一扫

微信扫一扫