新智元报道

来源:Google

编辑:雅新

谷歌研究人员提出了一种 LaBSE 的多语言 BERT 嵌入模型。该模型可为 109 种语言生成与语言无关的跨语言句子嵌入,同时在跨语言文本检索性能优于 LASER。

近日,谷歌 AI 研究人员提出了一种称为 LaBSE 的多语言 BERT 嵌入模型,该模型可为 109 种语言生成与语言无关的跨语言句子嵌入。 这一论文题目为「Language-agnostic BERT Sentence Embedding」,目前已在 arxiv 上发表。

论文地址:https://arxiv.org/pdf/2007.01852.pdf 研究背景

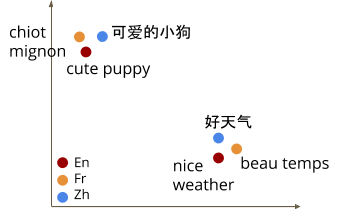

多语言嵌入模型是一种功能强大的工具,可将不同语言的文本编码到共享的嵌入空间中,从而使其能够应用在一系列下游任务,比如文本分类、文本聚类等,同时它还利用语义信息来理解语言。

用于生成此类嵌入的现有方法如 LASER 或m~USE 依赖并行数据,将句子从一种语言直接映射到另一种语言,鼓励句子嵌入之间的一致性。

尽管这些现有的多语言嵌入方法可在多种语言中有良好的整体性能,但与专用双语模型相比,它们在高资源语言上通常表现不佳。

此外,由于有限的模型容量、低资源语言的训练数据质量通常较差,可能难以扩展多语言模型以支持更多语言,同时保持良好的性能。

多语言嵌入空间的示例 改善语言模型的最新研究包括开发掩码语言模型(MLM)预训练,如 BERT,ALBER 和 RoBERTa 使用的预训练。由于这种方法仅需要一种语言的文字,因此在多种语言和各种自然语言处理任务中均取得了非凡的成就。

另外,MLM 预训练已经扩展到多种语言,通过将 MLM 预训练修改为包括级联翻译对,也称作翻译语言模型(TLM),或者仅引入来自多种语言的预训练数据。

但是,尽管在进行 MLM 和 TLM 训练时学习到的内部模型表示形式对下游任务进行微调很有帮助,但它们不能直接产生句子嵌入,而这对于翻译任务至关重要。

在这样情况下,研究人员提出了一种称为 LaBSE 的多语言 BERT 嵌入模型。

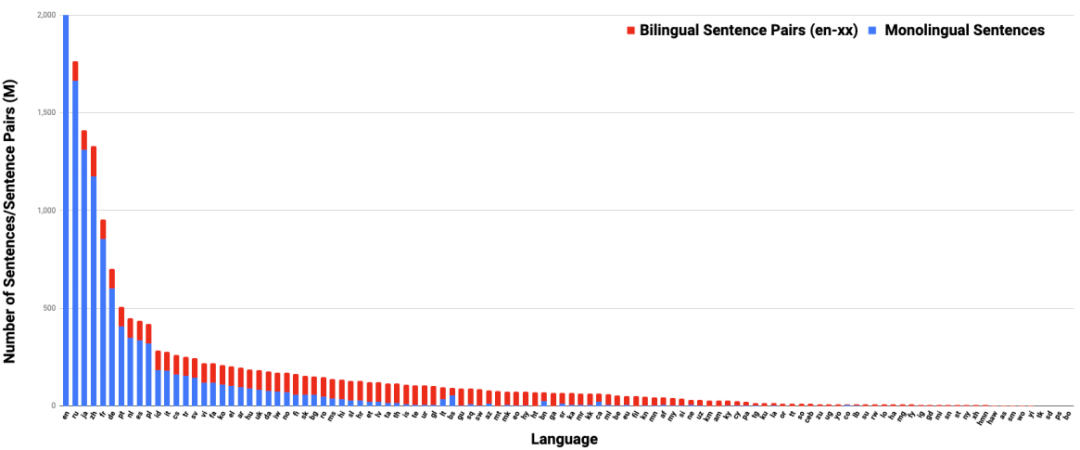

该模型使用 MLM 和 TLM 预训练在 170 亿个单语句子和 60 亿个双语句子对上进行了训练,即使在训练期间没有可用数据的低资源语言上也有效。 此外,该模型在多个并行文本检索任务上有表现出良好的性能。

收集 109 种支持语言的训练数据 LaBSE 模型可在单个模型中提供了对 109 种语言的扩展支持 在先前的工作中,研究者曾建议使用翻译排名任务来学习多语言句子嵌入空间。该方法通过给定源语言中的句子,对模型进行排序,从而对目标语言中的句子的正确翻译进行排名。

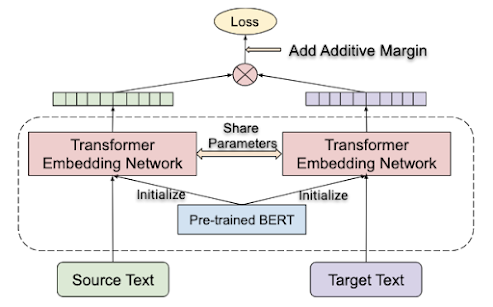

翻译排名任务通过使用带有共享变压器的双编码器体系结构进行训练的,让双语模型在多项并行文本检索任务表现出最先进的性能。

但是,由于模型能力、词汇量覆盖范围、训练数据质量等方面的限制,将双语模型扩展为支持多种语言(在研究者的测试案例中为 16 种语言)时,模型表现并不优。

翻译排名任务 对于 LaBSE,研究人员在类似 BERT 的体系结构上利用了语言模型预训练的最新成果,包括 MLM 和 TLM,并在翻译排名任务上进行了微调。

使用 MLM 和 TLM 在 109 种语言上预先训练的 500k 令牌词汇表的 12 层转换器,用于增加模型和词汇表覆盖范围。 最终,LaBSE 模型在单个模型中提供了对 109 种语言的扩展支持。

双编码器体系结构 LaBSE 模型在跨语言文本检索的性能优于 LASER

研究者使用 Tatoeba 语料库评估提出的模型,Tatoeba 语料库是一个数据集,包含多达 112 个语言的 1000 个英语对齐的句子对。

对于数据集中 30 种以上的语言,该模型没有训练数据。

该模型的任务是查找给定句子的最近相邻的翻译,并使用余弦距离进行计算。

为了了解训练数据分布的开头或结尾处的语言模型的性能,研究人员将语言集分为几组,并计算每组语言的平均准确性。

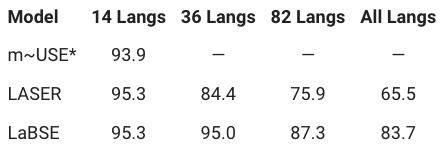

下表列出了与每种语言组的m〜USE、LASER 以及 LaBSE 模型实现的平均准确性对比结果。

可以看出,所有模型在涵盖大多数主要语言的 14 语言组中均表现出色。

当涵盖的语言增多,LASER 和 LaBSE 的平均准确度都会下降。

但是,随着语言数量的增加,LaBSE 模型的准确性降低的要小得多,明显优于 LASER,尤其是当包括 112 种语言的全部分发时,LaBSE 准确性为 83.7%,LASER 为 65.5%。

此外,LaBSE 还可用于从 Web 规模数据中挖掘并行文本。 谷歌研究人员已经通过 tfhub 向社区发布了预先训练的模型,其中包括可以按原样使用或可以使用特定于域的数据进行微调的模块。

链接:https://tfhub.dev/google/LaBSE/1

参考链接:

https://ai.googleblog.com/

支付宝扫一扫

支付宝扫一扫 微信扫一扫

微信扫一扫